AIgeist 14 │Quanta elettricità consuma l'AI oggi e nel futuro? │Dati, previsioni e leggende: domande e risposte │Speranze per il futuro e bollini verdi │Il sondaggio

Benvenuti in AIgeist, la newsletter settimanale che parla semplicemente di AI.

Ogni mercoledì alle 7. Le altre nostre newsletter: Finambolic (martedì), Xerotonina (giovedì)

Il tema è - Quanta elettricità consuma l'AI oggi e nel futuro?

“L’oscena richiesta di elettricità dell’AI” (The New Yorker, 9 Marzo 24)

“Il pantano energetico dell'intelligenza artificiale: i problemi urgenti di oggi, la crisi di domani” (Businessworld.in, 17 Marzo 24)

“Il boom dei data center per l’intelligenza artificiale creerà una crisi energetica” (Bloomberg.com, 25 Maggio 23)

Titoli preoccupanti, vero? Ma di quali dati disponiamo per credere a queste profezie drammatiche? E cosa si sta facendo per capire di più, e reagire alla situazione? Viaggio a domande e risposte sul tema dell’impatto energetico dell’AI, e un’approfondimento sulle soluzioni che già si vedono all’orizzonte.

Cosa sappiamo di quanto consumo ha aggiunto l’AI?

Poco, o nulla in realtà. Ma ci sono delle stime. Come spiega bene questo articolo di The Verge, quelli che pagano le bollette per l’AI - i Microsoft, i Google, i Meta - non danno risposte ufficiali. Qualcuno ha studiato (qui il PDF scientifico, citato nello stesso articolo) quanto consumi fare il “training” di un modello come GPT3 (non il servizio quindi, ma la parte che non si vede di apprendimento) ed equivarrebbe al consumo di 130 case di abitazione statunitensi per un anno. Non un gran numero.

Tutto nasce se vogliamo dall’intelligente blog del ricercatore indipendente dell’università politecnica VU di Amsterdam Alex De Vries. Lo studente ha sparato nell’ottobre 2023 un titolo che ha avuto uno straordinario successo: “Alimentare l’AI ci porterà a consumare come un piccolo Stato” (lui pensava al suo). Ci ha fatto un blog post e una ricerca completa pubblicata da una rivista scientifica e sul sito della sua università, e in pochi giorni BBC, New York Times, lo stesso The Verge e il New Scientist l’hanno ripreso creando il fenomeno mediatico.

Ci sono anche altre ricerche di natura scientifica sul tema, e qui citiamo quello realizzato alla Carnegie Mellon da un gruppo di ricercatori (qui trovate il pdf) che tenta un’analisi importante: questi modelli “orizzontali” di sapere, cosiddetti “multipurpose” (con più di uno scopo) sono più o meno efficienti di quelli “verticali” che fanno una cosa sola? La risposta, ancora da validare con peer review, è che non lo siano. E che i chip usati per l’AI siano molto più “affamati” di quelli cui siamo abituati. Ma se ancora non abbiamo certezze solide sui modelli, ma solo indicazioni che il consumo aumenterà, non vale forse la pena vedere “fisicamente” i posti dove questa energia viene consumata, vale a dire i data center?

Quanti data center verranno costruiti per far funzionare l’AI? E quanta energia consumeranno?

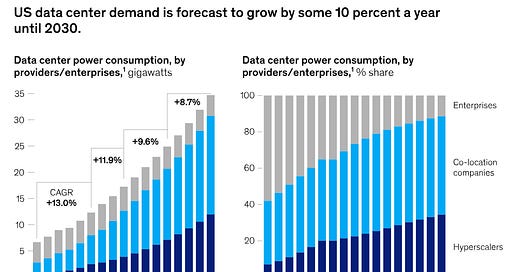

Un data center è un edificio, connesso alla rete Internet, che si alimenta ad energia elettrica e contiene computer e altri dispositivi elettronici che svolgono i compiti più diversi, sviluppando calore che viene smaltito con sistemi di raffreddamento, consumando ulteriore energia, acqua ed altre risorse naturali. Sicuramente queste strutture aumenteranno in numero e consumo di energia, e cambieranno natura. Guardiamo il grafico sotto:

Sono dati statunitensi (e gli Stati Uniti probabilmente cresceranno più dell’Europa, come abbiamo già scritto) ma la struttura è simile ovunque: il consumo di energia crescerà del 10% all’anno (composto) e si sposterà dai sistemi privati aziendali a quelli condivisi e soprattutto agli “hyperscaler”. Chi sono? Sono gli Amazon, i Microsoft eccetera che gestiscono giganteschi centri interconnessi per fare proprio cose come l’AI (si stima, come riporta questo articolo, che tra il 10 e il 15% di consumo di energia di Google sia proprio legato ad applicazioni AI).

Bene ma detto questo, di quanto stiamo parlando in senso assoluto? Di nuovo è difficile stabilirlo senza avere una palla di cristallo, e alcuni ricercatori sostengono una visione del tutto opposta, basandosi su evidenze: secondo per esempio questo studio del think tank Center for Data Innovation (in pdf) il numero e la potenza dei data center è aumentato verticalmente negli ultimi 10 anni, ma non è aumentato il consumo di energia a causa degli avanzamenti tecnologici.

Questo è solo in parte vero, perché questo tipo di sviluppo tecnologico si sarebbe fermato proprio negli ultimi anni, come spiega il grafici sotto:

Se invece crediamo a De Vries, e altri, oggi i data center (attenzione, in generale, non solo per l’AI) consumano l’1% dell’energia del pianeta, e producono lo 0.3% delle emissioni. E crescerà. Ma allora, che fare?

Sia come sia, c’è qualcuno che ne sta preoccupando?

Il primo paper scientifico dove si parla di Green AI è del 2015. Nemmeno dieci anni fa. Quindi il tema della sostenibilità è nato molto prima che noi mortali sapessimo qualcosa dell’esistenza delle molteplici applicazioni sviluppate con i Large Language Model e dell’uso che ora ne facciamo. A partire dal 2020 è stata coniata la definizione corrente dal prof. Roy Schwartz dell’università di Gerusalemme: “è verde quell'intelligenza artificiale che produca risultati innovativi tenendo conto del suo costo computazionale”. Mentre sembra che la rincorsa di OpenAI, Google, Meta sia quella di sviluppare modelli fagocitatori di enormi quantità di dati con aggiunta di molti parametri e quindi più energivori, alcuni scienziati mettono in dubbio la logica alla base di questa competizione. La ricercatrice Sara Hooker ha paragonato la ricerca di modelli sempre più grandi alla “costruzione di una scala per la luna”: costosa e inefficiente, senza un traguardo realistico. L’alternativa è dunque sviluppare modelli più piccoli ed efficienti attivando solo i parametri rilevanti per un dato input. Puntando sulla qualità e non sulla quantità. Avere dei dati puliti fornisce degli output validi con meno spreco. La speranza, aggiunge Hooker, è che presto nascano dei bollini verdi che attestino quali sono i modelli più efficienti dal punto di vista energetico, esattamente come facciamo per le costruzioni, gli elettrodomestici ecc. Altra ricetta proposta dai ricercatori dell’Università di Copenaghen è quella di considerare i costi climatici sin dalle fasi di progettazione dei modelli. Il loro paper “Energy Consumption Aware Tabular Benchmarks for Neural Architecture Search” attesta che adattandoli a un benchmark, è possibile ottenere un risparmio energetico del 70-80% durante la fase di formazione e implementazione, con una diminuzione delle prestazioni dell’AI solo dell'1%. Nel frattempo i big si muovono per assicurarsi nuove fonti per i mega data center. Microsoft punta sugli Small Modular Reactors (SMRs) -piccoli reattori nucleari a fissione- sull’energia rinnovabile e sulle potenzialità dell’AI per l’efficientamento. Come ha fatto Equinix, società di infrastrutture digitali, che ha appena costruito una copia di una server farm facendola gestire dall'intelligenza artificiale. Risultato: raffreddamento garantito dei server con un efficientamento della struttura del 9%. Sam Altman (il CEO di OpenAI) invece ha appena puntato 20 milioni di dollari nella startup nata a Miami Exowatt, che ha inventato una piattaforma che immagazzina l’energia solare in una batteria termica, utilizzabile per alimentare i data center. C’è anche chi, come Amazon, ha deciso di investire su tre startup: BrainBox AI, Pendulum e VIA. Ognuna di queste aziende sfrutta l’intelligenza artificiale generativa per ridurre gli sprechi di energia nei processi aziendali e nelle infrastrutture.

E io cosa posso fare, come utente?

Ecco le risposte che ci ha fornito ChatGPT.

Per usare le piattaforme AI in modo più efficiente e con un minor spreco di energia, puoi concentrarti su tre azioni principali:

Usa Modelli Pre-addestrati: invece di addestrare nuovi modelli da zero, utilizza quelli già addestrati che puoi semplicemente personalizzare. Questo riduce notevolmente il consumo di risorse computazionali.

Ottimizza le Richieste: fai domande chiare e dirette per ridurre il numero di interazioni necessarie e minimizzare il carico di calcolo necessario per generare risposte.

Scegli Provider Sostenibili: opta per servizi cloud che utilizzano data center alimentati da energie rinnovabili e che hanno politiche di efficienza energetica, per ridurre l'impatto ambientale del server che ospita ChatGPT.