AIgeist numero 11 │Performance e AI, come si misurano i LLM │I bot fatti in casa│Rewatch, il riassunto delle call funziona│Sondaggio: la vostra classifica di qualità

Benvenuti in AIgeist, la newsletter settimanale che parla semplicemente di AI.

Ogni mercoledì alle 7. Le altre nostre newsletter: Finambolic (martedì), Xerotonina (giovedì)

🚨Aigeist si prende una piccola vacanza e non uscirà mercoledì 3 Aprile. Torniamo il 10 Aprile con nuovi temi e rinnovata energia.

Il tema è - Le performance dell’AI

Ormai tutti noi abbiamo provato vari tool di AI, e a volte siamo stati delusi, a volte sorpresi positivamente. Ma esattamente come si misura la qualità di questi sistemi? C’è una classifica, e chi vince?

La risposta è molto complessa ma il nostro lavoro è semplificare, quindi proponiamo questa classificazione:

Il tool risolve problemi che conosciamo nella loro difficoltà, per esempio esami di accesso alle università

Il tool dà risposte positive perché lo confrontiamo a risposte date da umani o lo sottoponiamo a una community che prova a scoprire le magagne

Il tool rispetta dei criteri decisi a priori, etici, operativi o di semplicità di uso o commerciali (costa poco, consuma poca energia etc)

Quando abbiamo pensato di trattare questo tema siamo tornati con la mente a uno dei primi momenti dove ci siamo detti “questa cosa dell’AI è interessantissima, dobbiamo fare una newsletter”. E lo spunto è proprio un video che parla di qualità dei sistemi. Non è famoso, non è un Ted Talk, ma un semplice video interno (ma pubblico) dove Bill Gates circa un anno fa parla con un collega di Microsoft di una cena che ha tenuto a casa sua, dove una dozzina di cervelloni hanno detto “ok, ci siamo” a ChatGPT. La cosa migliore è vederlo raccontare in prima persona a questo link esterno ⏩(parte già nel momento giusto, ma tutto il video è interessante, visto che Gates è un maniaco di performance tecniche in generale ed il mastermind di OpenAI).

“Gli ho chiesto: riesce a superare l’esame di ammissione a biologia? Pensavo ci mettessero 2-3 anni, ma sono tornati dopo pochi mesi…”

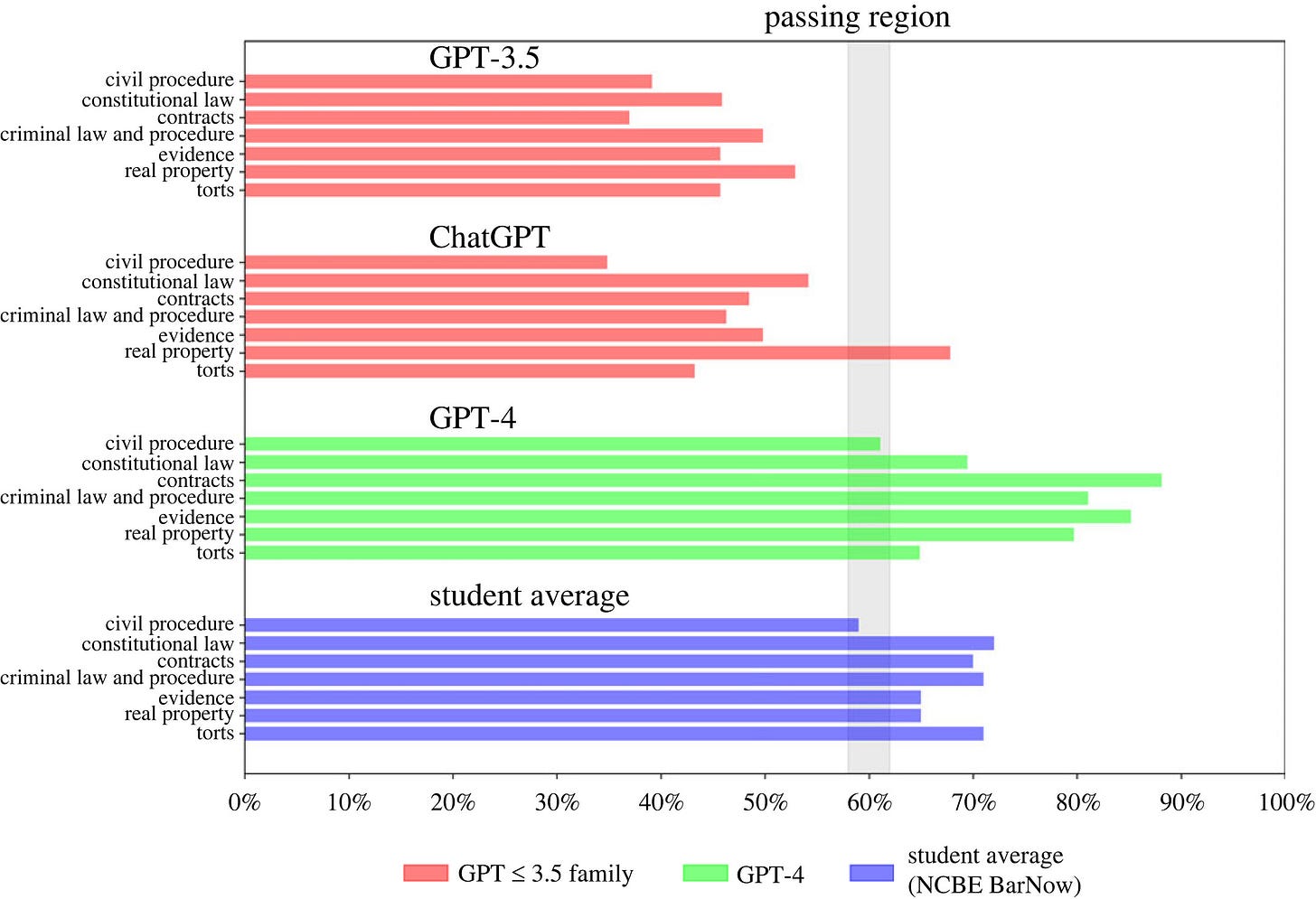

In realtà si è poi scoperto che GPT4, per esempio, sa fare molto di più. Questo paper spiega infatti in termini scientifici che sa superare una delle prove più difficili del sapere umano, l’esame per diventare avvocati negli USA – 12 ore di test sia a crocette che a risposte aperte.

Questo paper è stato uno dei momenti di svolta della breve storia dei modelli linguistici, perché ha avvicinato la realtà di quale qualità possa raggiungere un tool del genere. Questo articolo di Business Insider passa in rassegna tutti gli esami di ammissione che GPT o GPT4 hanno superato nel sistema statunitense, e sono davvero tanti.

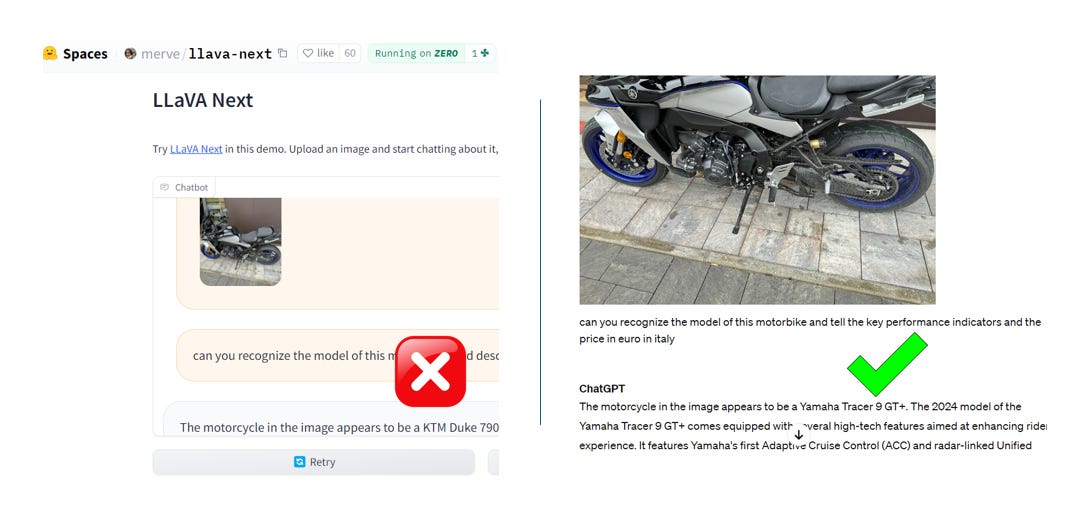

Venendo ora alle community e al confronto umano, un ottimo posto per partire è il sito Huggingface. Permette di caricare il proprio modello o sistema o applicazione di AI e consentire agli utenti di fare dei test dando anche dei feedback, e produce varie classifiche (popolare, recente, più usato). Per esempio noi abbiamo usato una applicazione di riconoscimento immagini che si chiama Llava next a questo link.

Abbiamo caricato l’immagine di una motocicletta speditaci da un amico, chiedendogli di riconoscerla e darci nome, caratteristiche principali e prezzo in Italia. Ha fallito malamente il test.

Riprovando su ChatGPT4 abbiamo avuto un risultato straordinariamente corretto, ricco di dettagli e informato.

Ma naturalmente un esempio non fa un’industria. Ci sono infatti là fuori legioni (“milioni”, dice un paper firmato Google) di umani che preparano i dati (“annotation”), sottopongono test ai sistemi e fanno altri lavori di miglioramento dei risultati (sono i ”taskers”). Questo articolo di The Verge ha provato a seguirne le tracce, ma c’è molto mistero intorno agli investimenti che l’industria dedica a varie forme di “reinforcement learning from human feedback,” o RLHF (vedi Wikipedia per capirne di più).

Ma quindi di che criteri disponiamo per valutare la qualità relativa tra le varie piattaforme?

Per andare più a fondo segnaliamo questo ottimo contributo che ci introduce alla grammatica elementare dei test (Helm, BigBench, Superglue eccetera), utile per partire con approfondimenti, come quello qui a seguire.

Da qui in poi tocca mettersi il cappello del nerd: questo paper è la rassegna più completa (e complicata, ma pubblica) di benchmark, criteri di valutazione eccetera che c’è in rete: è aggiornato a Febbraio 2024 e raccoglie anche test su sistemi aritmetici, risposte scientifiche e grafica - e produce una sua classifica. Lettura ostica e affascinante, la dedichiamo a chi tra noi (lo sappiamo che ci siete…) ha gli strumenti per farne uso – incluse competenze matematiche. Fa “scopa” con questa guida leggermente più accessibile dei sistemi di valutazione, arricchita da un ampio glossario.

Infine per la versione light del tutto, c’è chi ha fatto il lavoro per noi non tanto di trovare il bit di differenza (importantissimo) ma di incrociare le qualità dei vari tool con le esigenze umane (e basiche) degli utenti. Un grande grazie allora a questo articolo di ZDNet che fa questa utile mappatura e stila una sua classifica (giornalisticamente) definitiva - molto umana.

Da ricordare in breve> è in corso una gara tecnologica, finanziaria e culturale per vincere il premio di miglior sistema di AI nelle varie categorie. È nell’essenza stessa dei sistemi LLM di apprendere mentre operano, quindi i sistemi di valutazione sono in qualche modo incorporati a livello di codice nei sistemi. Ma questo non basta: la qualità dipende anche dalla percezione che gli “umani”, organizzati in community volontarie o pagati per farlo, hanno delle risposte. Classifica finale? Gemini di Google è un campione di programmazione e calcoli aritmetici complessi – tallonato da GPT4 che è fortissimo sul linguaggio naturale, ma non imbattibile (e sbaglia poco).

La risorsa è - Rewatch, il tool che trascrive e riassume le call

Video call noiose che si protraggono per ore, oppure intensissime, ma avete l’emicrania e non ci state dietro. L’AI viene in soccorso anche in questo campo. Noi abbiamo provato Rewatch il cui motto è meno stress durante i meeting e meno mal di testa (appunto). L’applicazione promette di fornirvi un riassunto di un minuto per ogni mezz’ora di riunione alla quale assistete. Dopo aver scaricato l’app sul pc va personalizzata la dashboard.

Ricordate di settare la lingua italiana altrimenti nel riassunto verranno tracciate solo le parole in inglese (tipo ok, stress, performance) e tutti i 6mila anglicismi che fanno parte ormai della nostra lingua. Un esercizio che andrebbe forse fatto per capire meglio che lingua parliamo, ma non efficace come report.

L’assistente virtuale, non registra però solo riunioni ma ogni azione che fate col pc o video che già avete, e la cosa più importante si connette con tutte le piattaforme di meeting online. Nella console appare come se fosse un invitato delle call, quindi è meglio chiedere prima ai partecipanti il permesso a registrare. Altra buona norma a cui attenersi è quella di allenarsi a usare il tool nei meeting che organizzate voi e poi estenderla a quelli a cui si partecipa, per capire bene il funzionamento di tutti gli strumenti che avete a disposizione (e il software lo raccomanda). Il riassuntino con i punti salienti della vostra call, che potete poi rivedere al minuto esatto, non è immediato ma il transcript è ottimo. Video, trascrizione parola per parole, recap e task da eseguire (ooops…) possono poi essere facilmente condivisi.

Utile per> Chiunque usi le video call nella sua routine lavorativa

🔗 Link: Rewatch.com

🪙Prezzo: gratis la prova che dura 14 giorni, poi ci sono due tipi di abbonamento a 19 dollari al mese per tre account e la versione custom enterprise con prezzo a richiesta.

L’idea è - Mi faccio l’Ai in casa

Negli Stati Uniti gli ultimi sondaggi condotti da alcuni istituti universitari hanno rilevato che una percentuale che varia da 50 al 65 per cento di studenti e docenti hanno già utilizzato ChatGPT o uno dei suoi concorrenti come aiuto alla scrittura o per preparare le lezioni. Appare dunque ovvio che le università siano corse ai ripari per creare in casa uno strumento simile che oltre ad svolgere i task richiesti potesse salvaguardare la proprietà intellettuale di quanto prodotto. Quella del Michigan è stata una delle prime che dopo il debutto di Chat GPT, a novembre 2022, ha creato un proprio strumento di intelligenza artificiale generativa gratuito che ora conta tra i 14.000 e i 16.000 utenti giornalieri. Poi i sono aggiunte le università di Harvard, Washington, quella delle California, Irvine e San Diego. L’obiettivo di tutte è di preservare la privacy, i diritti sul proprio operato senza creare discriminazione tra gli studenti: tutti devono accedere ai bot gratuitamente. Tutti gli atenei utilizzano la piattaforma Azure, che offre un software open source gratuito, ma hanno prima sottoscritto accordi con Microsoft affinché tutte le informazioni inserite nei loro modelli home made non saranno disponibili al pubblico.

A settembre la società di consulenza Ithaka S+R (che fa parte di ITHAKA , un'organizzazione no-profit che aiuta la comunità accademica a utilizzare le tecnologie digitali per promuovere la ricerca e l'insegnamento in modi sostenibili) ha formato una task force con 19 università, (tra le quali Princeton, Chicago e Carnegie Mellon) per studiare l'uso dell'IA generativa. Tra i primi prodotti nati un tracker, costantemente aggiornato, sugli strumenti ad hoc da utilizzare per l’insegnamento e la ricerca.

Il tallone d’Achille dei bot fatta in casa è che sono naturalmente autoreferenziali e quindi limitati alla conoscenze accumulate e schedate dai singoli enti e non aggiornati su tutto quello che circola al di fuori

E a proposito di motori intelligenti fai da te, dopo BloombergGPT si è aggiunto anche quello del Financial Times. Il quotidiano finanziario inglese ha debuttato con l’ASK FT, riservato a pochi abbonati per il momento, che è in grado di rispondere alle domande che afferiscono alle notizie archiviate ( se gli chiedete una ricetta di cucina non risponde, per capirci). Se si pensa che il giornale è uno strumento vivo fatto di notizie in continua evoluzione la meta ricerca potrebbe non avere molto senso. Forse potrebbe essere sfruttata da chi intende investire in un’azienda e ne vuole conoscere ad esempio la storia, gli avvicendamenti negli anni dei vari Ceo confrontando l’andamento del titolo, ma stiamo parlando di una nicchia. Anche la società di consulenza McKinsey ha costruito la sua squadra di 70 esperti per sviluppare Lilli, la soluzione di intelligenza artificiale generativa per aiutare i colleghi “a risparmiare tempo e trovare ispirazione” che possono smanettare in un archivio di dati che comprende 100.000 documenti provenienti da 70 paesi.

Tempo di lettura> 15 minuti

Il link: The Financial Times is ready for its AI to answer your questions (well, some of them)