AIgeist 41 │AGI, o dell'intelligenza artificiale generale: sogno, follia o invenzione del secolo? │La definizione e come si misura │ Le startup più avanzate │ L'attizzatoio del filosofo

Benvenuti in AIgeist, la newsletter settimanale che parla semplicemente di AI.

Le altre nostre newsletter: Finambolic (martedì), Xerotonina (giovedì). Abbonatevi, è gratis!

Si fa un gran parlare di AGI, Artificial General Intelligence. E di questo parliamo questa settimana, incrociando negazionisti, ottimisti, preoccupati, teorici e pragmatici.

Cominciamo dall’inizio: come possiamo definire l’AGI? Secondo 3 principi chiave, ci spiega l’AI stessa (qui, l’ottimo Perplexity.ai):

1. Abilità cognitive umane generalizzate: l’AGI mira a replicare l'intero spettro delle funzioni cognitive umane, inclusi ragionamento, risoluzione di problemi e apprendimento in vari ambiti. A differenza dell’AI ristretta, che è limitata a compiti specifici, l’AGI sarebbe in grado di comprendere ed eseguire autonomamente una vasta gamma di compiti.

2. Auto-apprendimento e adattabilità: si prevede che i sistemi AGI abbiano la capacità di apprendere dall’esperienza e adattarsi a nuove informazioni o ambienti, un po’ come apprendono gli esseri umani. Questo include la risoluzione di problemi complessi che non facevano parte della loro formazione originale.

3. Concetto di AI forte: l’AGI è spesso definita come "AI forte", in contrasto con "AI debole" o AI ristretta, che può gestire solo compiti predefiniti. L’AI forte implica un livello di intelligenza che raggiunge o supera le capacità cognitive umane.

Se vogliamo portare su un piano più pratico la questione, ecco qualche esempio sempre ad alto livello di cosa potrebbe fare:

Risoluzione autonoma dei problemi: l’AGI dovrebbe essere in grado di risolvere una varietà di problemi complessi in modo indipendente, senza intervento umano.

Conoscenza completa: possederebbe una vasta conoscenza in diversi campi e sarebbe in grado di applicare questa conoscenza in modo flessibile.

Funzioni cognitive di alto livello: questo include pensiero astratto, ragionamento di buon senso, percezione sensoriale e comprensione del linguaggio naturale.

In sintesi, l’AGI rappresenta un obiettivo ambizioso nella ricerca sull’AI, mirato a creare macchine in grado di pensare e apprendere come gli esseri umani in contesti e compiti ampi e diversi.

Ma siccome siamo in campo scientifico-tecnico, viene da chiedersi come si misura la vicinanza o meno all’AGI. E qui entriamo nel vivo, ed entrano in campo i big.

Il primo a cimentarsi (non dimentichiamo che è proprio da qui che nasce il paper essenziale su ChatGPT) è Google DeepMind, che con un suo gruppo di ricercatori ha pubblicato un paper dal titolo Levels of AGI for Operationalizing Progress on the Path to AGI (qui in PDF). Il documento allinea 9 casi esemplari che distinguono l’AGI dal normale calcolo computerizzato, e passa a descrivere sei principi e infine 5 livelli progressivi di intelligenza. Sono divisi in due tipi di applicazioni: quelle “narrow” (ristrette a domini verticali, pensiamo alla musica o agli scacchi) e quello generalista, su tutto lo scibile e l’agire umano, cioè la “vera” AGI come la immaginiamo.

Ecco dove siamo e potremmo arrivare sui 5 livelli secondo Deepmind:

🧠Livello 0: NO AI: nel caso ristretto riguarda per esempio la calcolatrice elettronica; in quello ampio la ripetizione meccanica di operazioni semplici via computer

🧠Livello 1: EMERGENTE: uguale o vagamente meglio di un umano senza competenze specifiche. Qui ci sono ChatGPT e Gemini, per capirci

🧠Livello 2: COMPETENTE come almeno il 50% di un adulto, appunto, competente. Qui nel caso verticale ci sono Siri, Amazon Alexa, Google assistant e simili

mentre non esiste un caso ampio e generalista, e non ce ne saranno più da qui in poi

🧠Livello 3: ESPERTO: sa eseguire compiti verticali come il 10% di adulti esperti. Qui ci sono strumenti come Grammarly, Imageno, Dall-E

🧠Livello 4: VIRTUOSO, qui si spinge solo l’1% degli umani e ci sono solo applicazioni superverticali come AI Deep Blue e AlphaGo

🧠Livello 5: SUPERUMANO eccede le capacità del 100% degli umani. Ci sono già applicazioni verticali come Alphafold (campo medico), AlphaZero e Stockfish, entrambe dedicate unicamente al gioco degli scacchi

Leggendo questa tabella si capisce che l'AI generalista si ferma ora al livello 1 di 5, dunque c’è ancora tanto spazio da riempire. Ma chi se ne sta occupando in pratica?

Chi ci sta lavorando e le previsioni

Nonostante i paper e le classifiche Fei-Fei Li, la pioniera dell’AI- non una qualunque, ammette di non aver ancora capito bene cosa significhi AGI:

Come si dice, lo sai quando lo vedi, immagino di non averlo visto. La verità è che non passo molto tempo a pensare a queste parole perché penso che ci siano così tante cose più importanti da fare...

Vediamo invece chi le idee chiare le ha e ci sta già lavorando, anche se le difficoltà non mancano. Per arrivare a creare modelli di intelligenza artificiale avanzati servono infatti soldi per le infrastrutture (7 trilioni di dollari per costruire 36 stabilimenti di semiconduttori e ulteriori data center) e contenuti di alta qualità che pare stiano scarseggiando. La lotta per chi li svilupperà per primi è tra i soliti noti: Microsoft, OpenAI, Google e Anthropic.

Per quanto riguarda la tempistica per Sam Altman (OpenAI) occorrono ancora 5 anni per sviluppare gli AGI veri e propri. Il CEO di Anthropic, Dario Amodei, più ottimista, pensa invece che gli AGI saranno operativi entro il 2026 o al massimo l’anno dopo. La sua previsione si basa sulle curve di progressione dell’apprendimento dei modelli, che attualmente si stanno avvicinando al livello di intelligenza di un umano con dottorato. In ogni caso, afferma Amodei, l’intelligenza umana sarà superata da un’AI che saprà essere molto più smart:

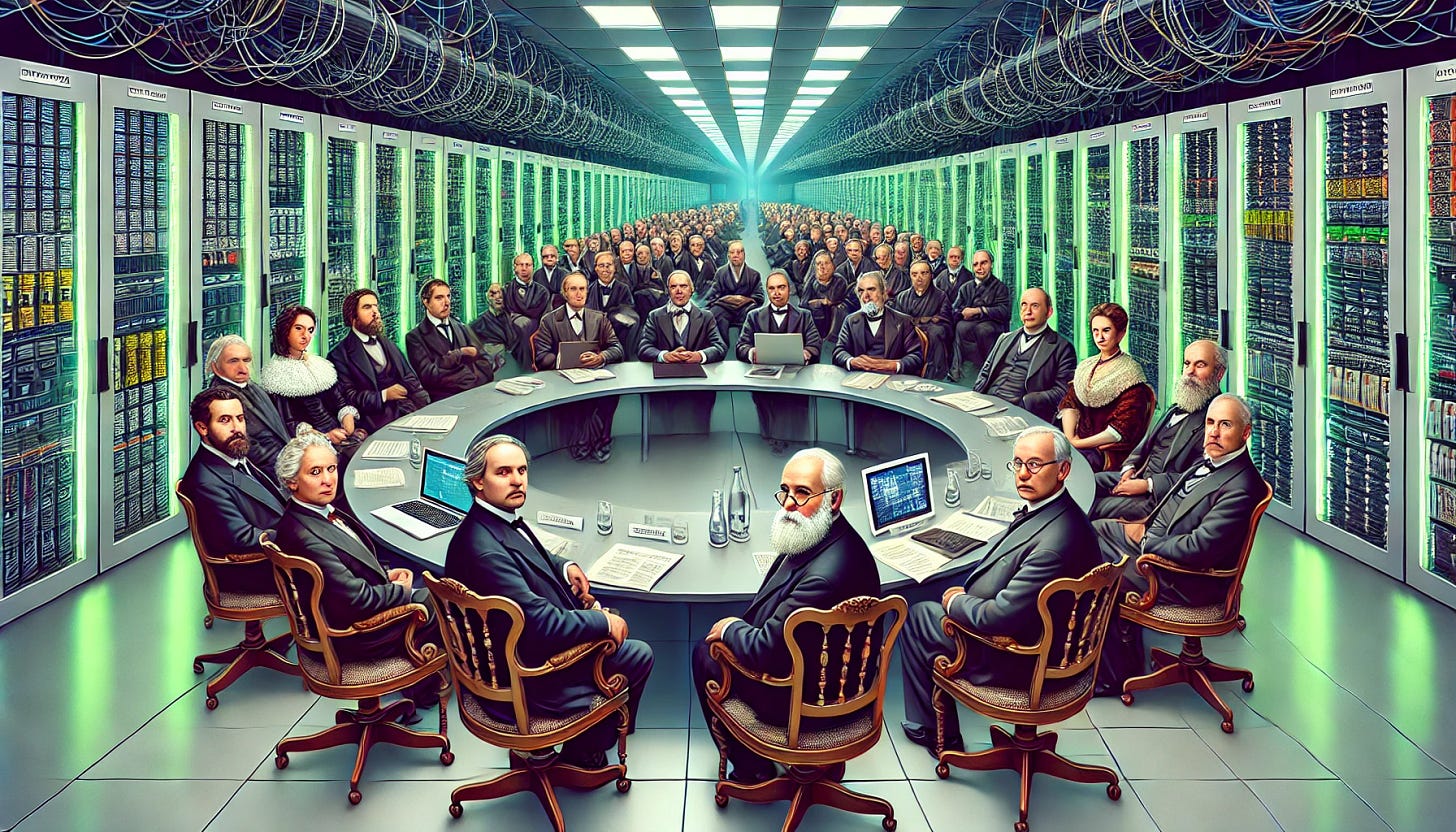

“sarà come avere un congresso di geni che pensano in un datacenter”

Più cauto Demis Hassabis, CEO di Google DeepMind. Per avere un’intelligenza turbo che pensa come noi ci vorranno ancora una decina d’anni. C’è anche chi, come Richard Socher, ex dirigente di Salesforce che ora è l’AD del motore di ricerca basato sull’AI, You.com, pensa che per avere una forma di intelligenza in grado di “imparare come gli esseri umani e avere visivamente la stessa intelligenza motoria, visiva, linguistica e logica”, bisognerà avere molta più pazienza. Parliamo dai 10 ai 200 anni. La previsione di Yann LeCun, a capo dell’AI di Meta, è invece di decenni: “sarà un processo graduale e lento”. E per finire l’ipotesi temporale del fisico Geoffrey Hinton, il padre dell’AI,

“Ci vorranno ancora dai 5 ai 20 anni. Viviamo in tempi molto incerti e non ho molta fiducia in un progresso in accelerazione”

Poi ci sono le startup che vogliono prendersi una fetta di un mercato che supererà i 27 miliardi di dollari entro il 2030. Questo articolo ne ha individuate cinque che stanno raccogliendo centinaia di milioni di dollari, come Imbue.com, finanziata da Nvidia, che addestra grandi modelli linguistici (con oltre 100 miliardi di parametri) progettati per eccellere in attività di ragionamento.

Poi c’è Numenta, fondata dall’informatico e neuroscienziato Jeff Hawkins che, in partnership con Intel, vuole sviluppare AGI attraverso la sua Teoria dei Mille Cervelli in uno. L’azienda sta sviluppando modelli computazionali che mirano a replicare la funzionalità della neocorteccia, la parte del cervello maggiormente associata all’intelligenza. Munjal Shah, co-fondatore e CEO, Hippocratic AI sta invece investendo nella ricerca AGI con un focus sullo sviluppo della Health General Intelligence (HGI). L’obiettivo è quello di affrontare la carenza globale di professionisti sanitari creando agenti AI generativi in grado di eseguire attività a basso rischio, non diagnostiche e rivolte ai pazienti.

Insomma c’è fermento e scorrono i “soliti” fiumi di denaro. Ma alla fine non stiamo solo parlando del problema più vecchio del pensiero, cioè il pensiero stesso? Scendano allora in campo gli specialisti.

L’attizzatoio del filosofo

Vogliamo concludere questa disamina su intelligenza artificiale e umana con un episodio avvenuto a Cambridge nell’ottobre del 1946. Siamo in una stanza con camino nella famosa università inglese, e si ritrova a dibattere al periodico incontro del Cambridge University Moral Sciences Club un pugno di geni dell’epoca: tra loro, Karl Popper e Ludwig Wittgenstein (che era filosofo, ma anche ingegnere e matematico). Era proprio lui ad organizzare l’incontro, intitolato “Esistono davvero problemi filosofici?”. La discussione si scalda, Wittgenstein chiede all’ospite, brandendo pericolosamente un attizzatoio: “Mi spieghi cos’è una regola morale”? La risposta fu “non minacciare i propri ospiti con un attizzatoio”. Il filosofo austriaco fece cadere l’oggetto e lasciò la stanza di corsa. Perché ve ne parliamo? Perché alla fine saper pensare è anche saper lottare per le proprie idee, dargli corpo e prendersi dei rischi, tutte cose molto, molto umane.

PS: Per chi fosse interessato come noi alla relazione tra il pensiero di Wittgenstein e gli sviluppi recenti dell’AI consigliamo la lettura dell’agile paper del professore genovese Carlo Penco “Wittgenstein, Contexts, and Artificial Intelligence - An Engineer Among Philosophers, a Philosopher Among Engineers” (qui in pdf). E si parla anche della già famosa “stanza cinese”…