AIgeist 47 │💞 Emozioni artificiali e 🧠intelligenze emotive │Come si generano e misurano i sentimenti sintetici │ Startup e tools online │Come si applica a lavoro e business

Benvenuti in AIgeist, la newsletter settimanale che parla semplicemente di AI.

Le altre nostre newsletter: Finambolic (martedì), Xerotonina (giovedì). Abbonatevi, è gratis!

È dagli anni Novanta, precisamente dal 1995, quando è stato pubblicato il libro “Emotional Intelligence”- in italiano è stato stampato due anni dopo- che si parla di Intelligenza Emotiva. Il saggio di Daniel Goleman, psicologo, scrittore e giornalista californiano, diventato presto un best seller, spiegava in modo semplice un concetto chiave che sta alla base delle relazioni interpersonali cioè il nostro quoziente intellettivo che comprende autocontrollo, pervicacia, empatia e attenzione agli altri. In breve Goleman è stato il primo a divulgare il pensiero che alla base del successo nelle relazioni anche professionali e della leadership non c’è solo il QI (quoziente intellettivo riferito alle abilità cognitive ) ma una gamma di capacità per comprendere e gestire al meglio le proprie emozioni e lo stress e allo stesso tempo leggere e capire quelle degli altri. Ora questa abilità “di leggerci la faccia” che noi abbiamo incorporata da duemila anni sta per essere acquisita anche dalle macchine AI.

Perché ne parliamo e cosa significa in relazione all’AI

L’attribuzione di emozioni alle macchine è un tema letteralmente vecchio come la tecnica moderna. Il campo più classico di applicazione è quello dei robot, soprattutto di quelli cosiddetti “sociali”, che vivono tra le persone e interagiscono con esse. Le molte ricerche sul tema non sono però definitive e quindi faticano a fornire una base di ragionamento nel campo dell’AI. Se infatti molti pensano che i robot più simili agli esseri umani (nel gergo tecnico, “simulatability“) possano trasmettere quella “confidenza emotiva” da renderli accettabili, altre ricerche sostengono l’esatto contrario e spostano la discussione su un terreno molto interessante: quello della percezione del potere e gerarchie di dominanza, ben spiegata in questo paper.

Come sostiene la ricerca la “forma” dei robot deve essere tale da non incutere timore e per noi umani il segnale è che sappiano fare cose che noi non sappiamo fare. Insomma, un robot che cammini bene, o balli, anche – soprattutto! - se ci somiglia non ci spaventa. Se il robot spiccasse il volo, o distruggesse un muro con un pugno, allora lo respingeremmo, soprattutto se ha forme umane. Preferendo quindi forme ben diverse dalle nostre che in qualche modo evidenzino proprio le loro limitazioni (con design più piccoli, buffi o bizzarri).

Come si applica tutto questo all’AI? Dobbiamo spostare la discussione su due livelli: servizi AI che “ci parlano” direttamente e altri che sono solo a supporto del lavoro che fa lo strumento.

Facciamo degli esempi: un bot che ci fa da compagno di chiacchierate, fidanzato, amico o psicologo cade nel caso primo. Un sistema che permette di leggere le nostre emozioni da un video o ascoltando la nostra voce entra nel caso 2.

Voci e facce dell’AI

Partiamo dalla cima: OpenAI. La casa di ChatGPT ha messo in guardia i propri utenti sull’uso di ChatGPT come “compagno”, temendo l’impatto proprio sulle emozioni. Nel lavoro che sta compiendo per creare “guardrails” nello sviluppo del servizio (qui un riassunto dei casi e delle attività) tocca proprio il potere emotivo della voce come problema essenziale. Questo articolo di CNN passa in rassegna questo e altri casi di possibili interferenze, senz’altro rese più rilevanti da casi come quello del 14enne statunitense che si è suicidato dopo ore di interazione con un “companion” AI creato dalla piattaforma Character.ai. L’interazione qui era solo testuale e l’errore è stato non tentare di fermare le idee dissennate del ragazzo, ma immaginate l’effetto di qualcosa anche più controllato unito a una voce molto convincente.

La community online di OpenAI ha decine di aree di discussione legate a questi temi, alcune con contenuti davvero estremi. A questo link ne trovate una, dove un utente dichiara candidamente “Fondamentalmente sto dicendo che l’amore è informazione, e tutto ciò che dobbiamo fare è duplicare quell’informazione in una macchina”. Un po’ poco.

Se poi facciamo un passo oltre e dal testo e la voce passiamo ai volti virtuali che possono veicolare contenuti AI aggiungendo emozione, entriamo nel campo della “Complex Expression Generation”. Qui ci sono due dimensioni da considerare: quella interamente digitale (video interattivi che simulano emozioni) e quella fisica – visi robotici come Eva (vedi sotto) che sono in grado di riprodurre un’alzata di sopracciglia o un ampio sorriso. Obbiettivo finale, l’uomo robotico che comunica emozioni con verosimiglianza estrema, come spera il progetto Ameca, per esempio.

L’AI che legge le emozioni: opportunità e rischi

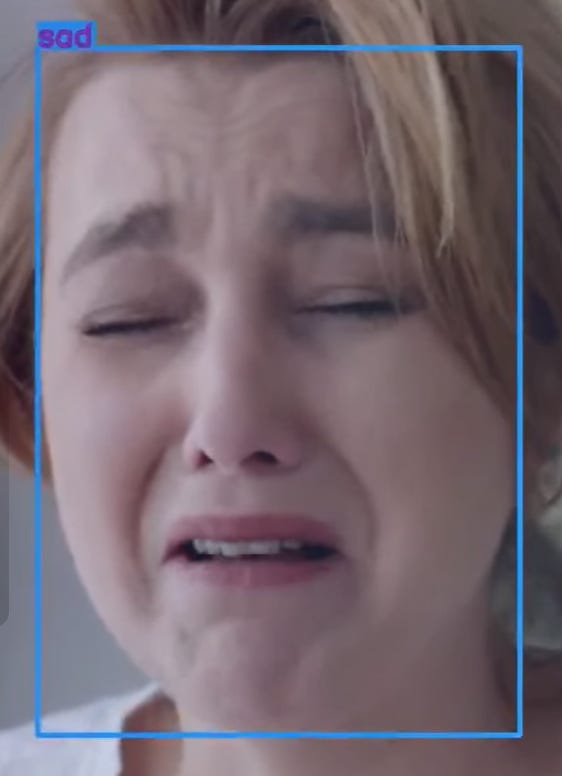

Ora rovesciano la visuale e preoccupiamoci dei sistemi che permettono di decodificare le nostre espressioni – vocali, fisiche, le espressioni del viso – usando l’AI come motore di analisi potentissimo. Anche qui, tema non nuovo: pensiamo alle macchine della verità dei film in bianco e nero, ma in versione real time e fatti di mille sfumature: sono stanco ma anche rilassato e lievemente ansioso? Oppure felice ma frettoloso?

Qui gli strumenti a disposizione sono tanti, e sotto ne passeremo in rassegna alcuni. In questa introduzione possiamo solo rinnovare il messaggio: sono strumenti potenzialmente pericolosi, e il training “emozionale” è in corso ormai da anni. Questo articolo scritto dall’autrice italiana Paola Cozzi è un eccellente punto di partenza per inquadrare anche storicamente il fenomeno, e le sue molteplici sfaccettature etiche e scientifiche. Questo contributo invece passa in rassegna i potenziali rischi, e lo fa elencando casi specifici e toccando il delicato punto del “bias”: proprio perché parliamo di emozioni, pensiamo a quanto bias ci possa essere nella loro lettura.

Facciamo un caso semplice e di tutti i giorni: un infermiere e un medico come reagiranno alla vista del sangue rispetto a una persona qualunque? E questo significa che sono meno sensibili, o non sono toccati dalla situazione? O piuttosto che hanno un’abitudine diversa a vedere quella cosa? E come la mettiamo con i tratti culturali, la provenienza geografica o l’educazione? Alla fine la domanda è: questi sistemi indirettamente – come pare stia già avvenendo con la scrittura – per così dire “retrofitteranno” (leggi aggiorneranno) il modo in cui esprimeremo le nostre emozioni perché noi, animali adattabili per eccellenza, ci adegueremo ad essere monitorati in questo modo?

Startup e tools online

Prima della carrellata delle startup che mettono sotto la lente AI le emozioni e le sanno interpretare va detto che più gli strumenti di intelligenza artificiale entrano nel nostro ufficio più ci farà comodo e ci porterà vantaggio sviluppare quella emotiva. Ad affermarlo, tra gli altri, questo articolo di Forbes i dipendenti con un alto "EQ" (quoziente emotivo) guadagnano in media 29.000 dollari in più all’anno rispetto alle persone con un basso EQ. In media, ogni punto di aumento dell’intelligenza emotiva aggiunge 1.300 dollari a uno stipendio annuale. Secondo uno studio di LHH società del Gruppo Adecco tre quarti dei responsabili delle risorse umane utilizzano l’EQ per determinare promozioni e aumenti di stipendio. In breve, nonostante sia ancora purtroppo in uso, il capo che sbrocca e urla in ufficio ha sicuramente un EQ molto piccolo 🤏 e varrebbe la pena di dirglielo.

➡️qui un paper di approfondimento sulla connessione tra intelligenza artificiale e intelligenza emotiva necessaria per avere successo nel mondo aziendale

Tra le startup che allevano simulacri digitali che imparano le emozioni interagendo con gli umani c’è Antix. Si tratta di una piattaforma che crea avatar programmati per rispondere ad esempio con simpatia quando riconoscono sentimenti di frustrazione, rabbia o turbamento nelle persone con cui interagiscono. Ogni umano digitale è un token non fungibile o NFT unico che impara nel tempo dai suoi utenti, acquisendo più conoscenza ed evolvendosi in modo da poter adattare le sue interazioni in risposta al comportamento o alle preferenze di un individuo.

Hume invece offre il giusto tone of voice per ogni chatbot in grado di connettersi emotivamente meglio con gli esseri umani. L’azienda propone una gamma di personaggi vocali emotivi e la possibilità di calibrare la propria con qualità specifiche come “spensieratezza”, “timbro nasale” e “assertività”.

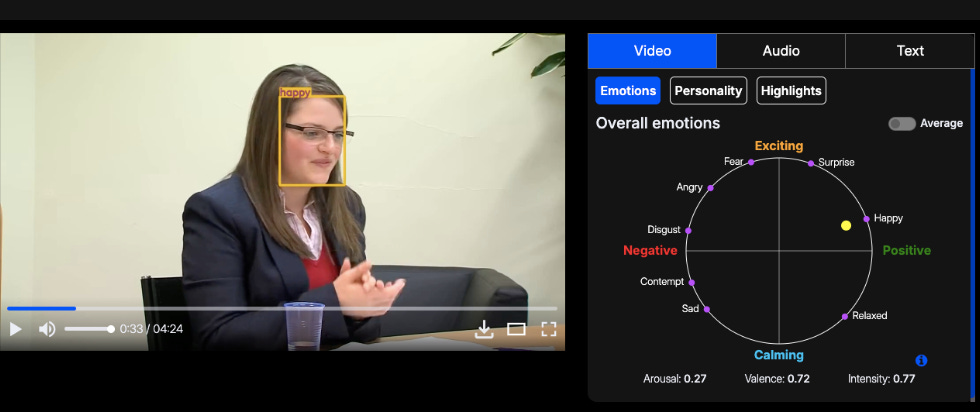

Imentiv AI invece lavora sull’analisi dei video con l’AI e analizza le emozioni dei protagonisti fornendo report dettagliati sul loro impatto emotivo. L’obiettivo è di fornire analisi in grado di migliorando l’engagement e renderli più accattivanti e profittevoli (vedi lo studio della campagna pubblicitaria di Patagonia).

L’applicazione non ha solo un ruolo profit. Nel loro blog, ad esempio, viene spiegato come gli algoritmi di apprendimento automatico per rilevare e analizzare gli stati emotivi siano anche in grado di rilevare nei video segnali di autolesionismo o intenzioni suicide (micro-espressioni facciali e variazione di tono, pause prolungate, fissità ecc.) diventando uno strumento utile di supporto per l’analisi dello stato di salute mentale in un paziente monitorato da remoto.

Infine qui una carrellata di tool che analizzano le espressioni facciali in diversi contesti, come Morphcast che, tra le tante applicazioni, ha quella in grado di tracciare in tempo reale il vostro coinvolgimento durante una call o un colloquio di lavoro. Fate attenzione alla prossima riunione o fatevi furbi e tirate fuori il vostro EQ per mostrarvi partecipi, anche se vi annoiate a morte 😱.